线性回归

简介

特点

一个事物唯一由另一个事物决定

线性

类似二元直角坐标系,描出关系图形是一条直线,称为线性关系

回归

回归分析是一种统计方法,于对具有一个或多个自变量的因变量(目标变量)和自变量(预测变量)之间的关系进行建模。具体地说,回归分析有助于我们理解在其他自变量保持固定的情况下,自变量的值对应于自变量的变化方式。它可以预测连续/实际值,例如温度,年龄,工资,价格等。

回归是一种有监督的学习技术,有助于发现变量之间的相关性,并使我们能够基于一个或多个预测变量来预测连续输出变量。它主要用于预测,时间序列建模以及确定变量之间的因果关系。

简单线性回归模型

$$\hat{y}= h(x) = w*x +b $$其中$w$叫权重参数,$b$叫偏置或者截距。当求解得到未知参数$w$,$b$之后,也就意味着我们得到了这个预测模型。假设给定一个房屋面积$x$,就能够预测出其对应的房价。

求解线性回归模型

当建立好一个模型后,自然而然想到的就是如何通过给定的数据,也叫训练集(Training Data),来对模型$h(x)$进行求解。在中学时期我们倒是学过如何通过两个坐标点来求解过这两点的直线,可在上述的场景中这种做法显然行不通的(因为所有的点并不在一条直线上),那有没有什么好的解决的办法呢?

此时就需要我们转换一下思路了,既然不能直接来进行求解那就换一种间接的方式。现在来想象一下,当$h(x)$满足一个什么样的条件时,它才能称得上是一个好的$h(x)$? 回想一下求解$h(x)$的目的是什么,不就是希望输入面积$x$后能够输出”准确”的房价$h(x)$吗 ?既然直接求解$h(x)$不好入手,那么我们就从“准确”来入手。

可又怎么来定义准确呢?在这里,我们可以通过计算每个样本的真实房价与预测房价之间的均方误差来对“准确”进行刻画

$$ J(w,b) = {1 \over 2m} \sum_{i=1}^{m} \left ( y^{(i)} - \hat{y^(i)} \right ) ^2 $$ $$\hat{y}^{(i)} = h(x^{(i)}) = wx^{(i)}+b$$其中,$m$表示样本数数量$x^{(i)}$表示第$i$个样本的,也就是第$i$个房屋的面积;$y^{(i)}$表示第$i$个房屋的真实价格;$\hat{y}^{(i)}$表示第$i$个房屋的预测价格。

由式可知,当函数$J(w,b)$取最小值时的参数$\hat{w},\hat{b}$,就是要求的目标参数。为什么?因为当$J(w,b)$取最小值就意味着此时所有样本的预测值与真实值之间的误差(Error)最小。如果极端一点,那就是所有预测值都等同于真实值,此时的$J(w,b)$就是0了。

代价函数

因此,对于如何求解模型$h(x)$的问题就转换成了如何最小化函数$J(w,b)$的问题。而$J(w,b)$也有一个专门的术语叫目标函(Objective Function)或者是代价函数(Cost Function)亦或是损失函数。

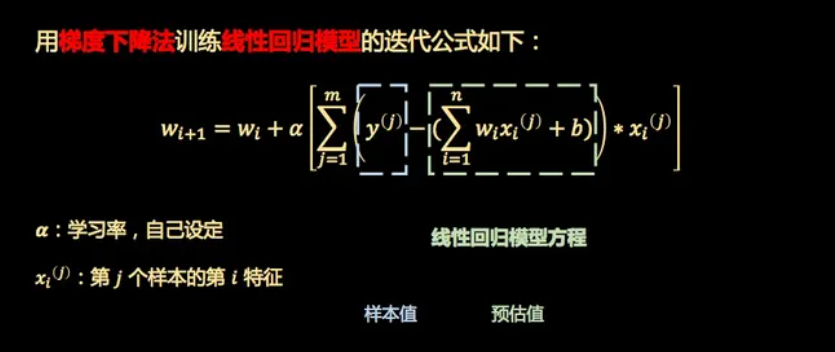

梯度下降