1124组会

数值分析的思想

地震观测实践学习

深度神经卷积网络的学习

CNN的经典论文

(MLP)MULTILAYER FEEDFORWARD NETWORKS ARE UNIVERSAL APPROXIMATORS

为什么提出:为了解决感知器只能处理线性可分问题的局限,增加了隐藏层,通过非线性激活函数,使得网络能够逼近任意复杂的函数。

优点:通用性比较强,可以用于分类、回归等多种任务

缺点:参数量大,对高维输入(如图像)的处理效率低。无法捕获输入数据的局部结构和空间信息。

(LeNet)

为什么提出:设计用于手写数字识别的专用架构,克服 MLP 在处理图像任务时的参数膨胀问题。

解决的问题:提出了卷积操作,通过局部连接和权值共享,减少了参数数量。增加了池化操作,增强了平移不变性。

优点:有效处理图像数据。引入卷积神经网络(CNN)的基础结构。

缺点:网络较浅,特征提取能力有限。计算能力依赖于硬件受限于但是的技术水平。

(AlexNet)ImageNet Classification with deep convolutional neural networks

为什么提出:通过深度卷积网络和 GPU 加速,在 ImageNet 数据集上实现突破性性能。

解决的问题:使用ReLU激活函数加速收敛。引入Dropout 解决过拟合问题。使用 GPU 提高计算效率。

优点:网络较大,参数量和计算量仍然较高。过于依赖硬件资源。

创新点:ReLU、Dropout、重叠池化、数据增强等技术。

(NiN)

为什么提出:用更灵活的模型代替传统卷积层,解决 CNN 中特征提取的局限性。

解决的问题:引入 1x1 卷积 以增加网络的表达能力。每个卷积操作后加一个小型 MLP(即“网络中的网络”)进行特征学习。

优点:大幅度减少参数量。增强特征提取的非线性能力。

缺点:网络深度较浅,在更复杂任务中表现受限。

(VGG)

为什么提出:探索网络速度对性能的影响。

解决的问题:通过堆叠多个3*3卷积核,保持感受野不变的同时提高网络的深度。

优点:结构简单,易于实现。深度增加后性能显著提升。

创新点:全部使用小卷积核,控制参数量同时增加深度。

(GoogleNet)

为什么提出:提升深度网络的计算效率,减少计算量和参数量。

解决的问题:引入 Inception 模块,结合多种卷积核(1x1, 3x3, 5x5)和池化操作,提取多尺度特征。使用 1x1 卷积 进行降维,减少计算量。

优点:参数量少,计算效率高。更适合大规模图像分类任务。

缺点:模块设计较为复杂。手动调参难度较高。

创新点:Inception 模块的模块化设计,适合扩展。

(ResNet)Deep Residual Learning for image recognition

为什么提出:解决深度网络的 梯度消失/爆炸 问题。

解决的问题:引入 残差连接(Residual Connections),通过恒等映射缓解深度网络的训练难度。深度增加后网络性能不再下降。

优点:支持超深网络(如 152 层)训练。大幅提高网络的表达能力。

缺点:计算量较大。对硬件资源要求较高。

创新:残差连接使深度网络训练更加稳定。

深度学习的综述文章

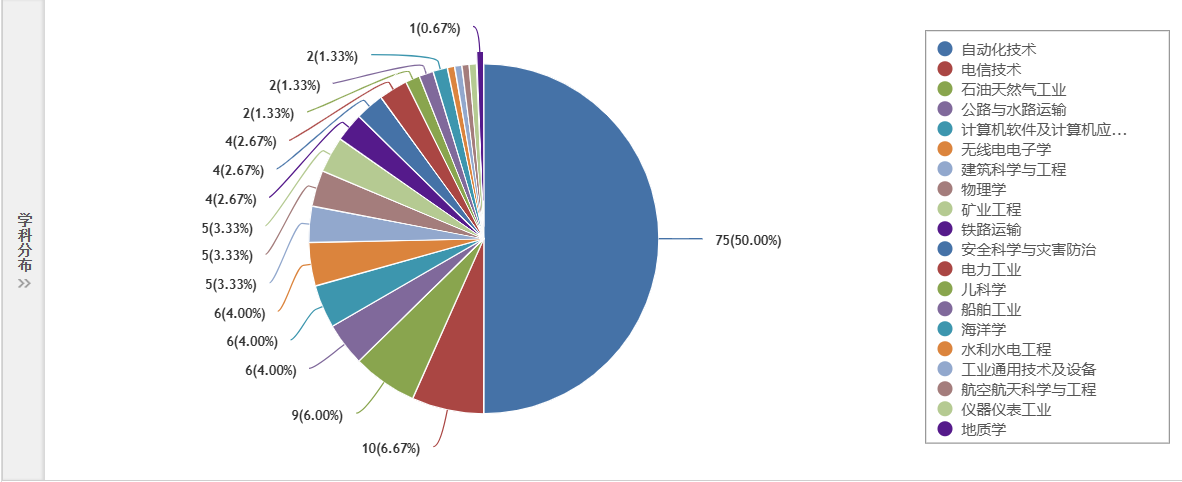

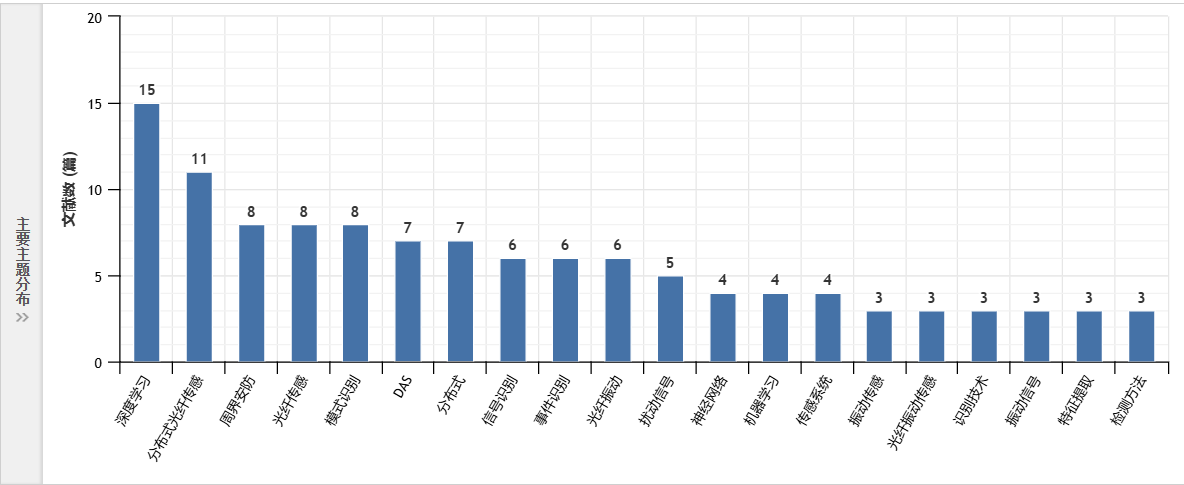

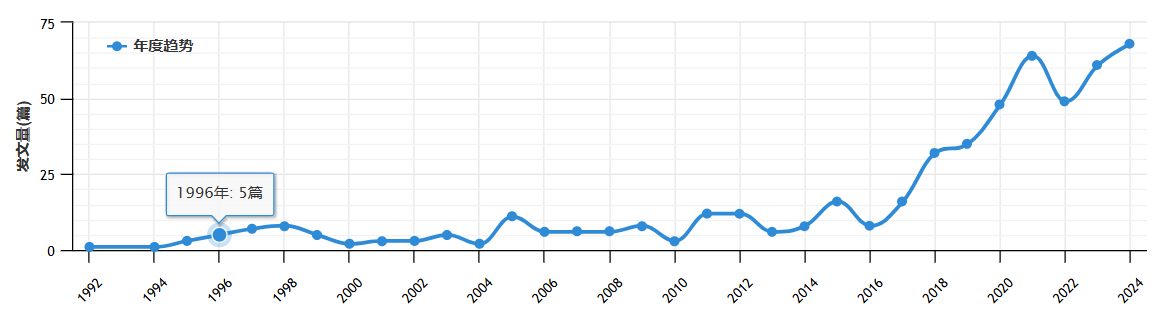

CNN&分布式光纤结合的论文

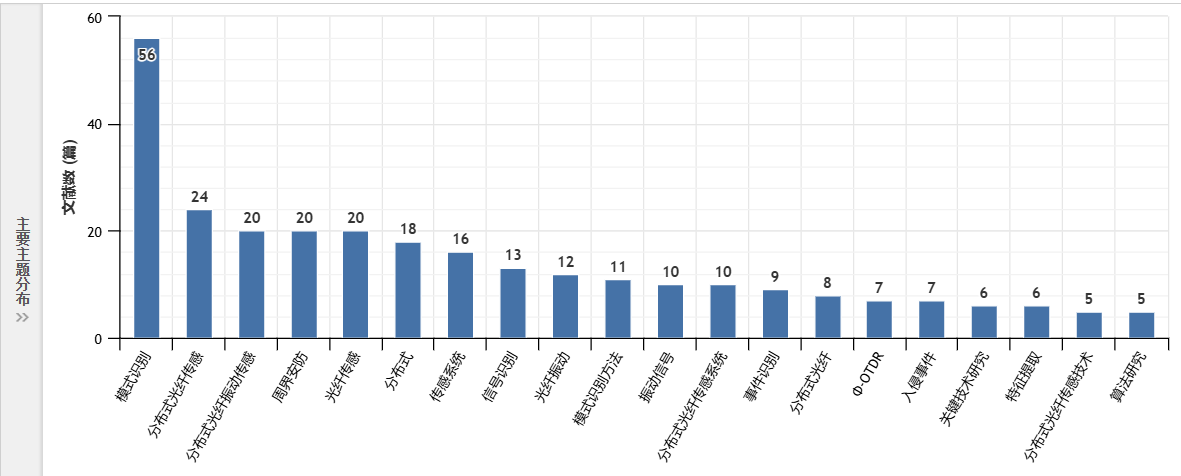

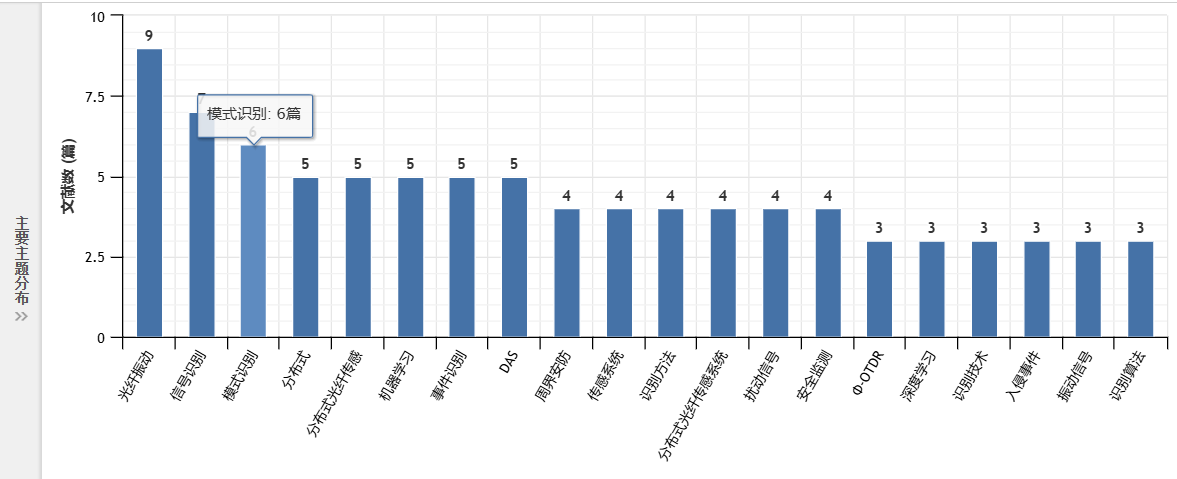

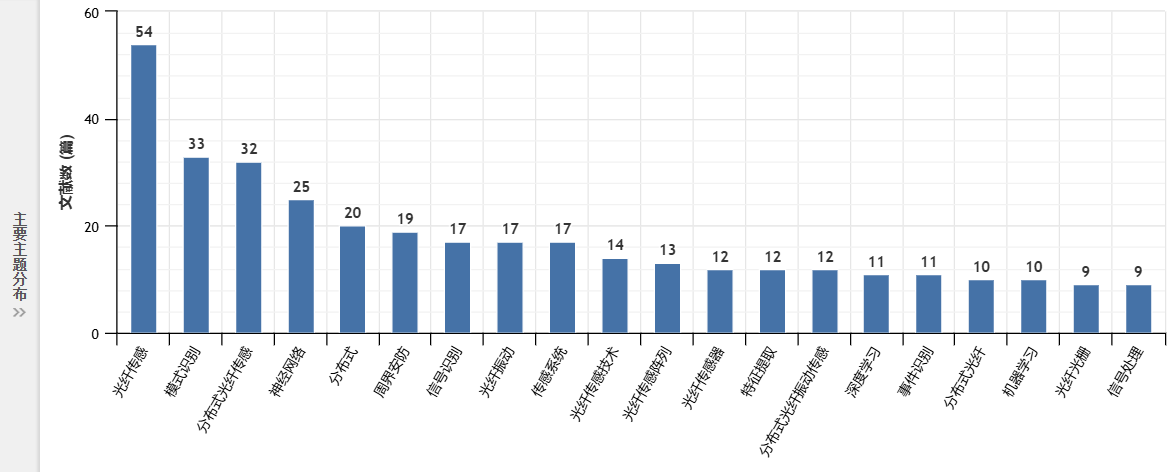

关键词:光纤传感、模式识别

来源:EI、北核等

引用:三四百

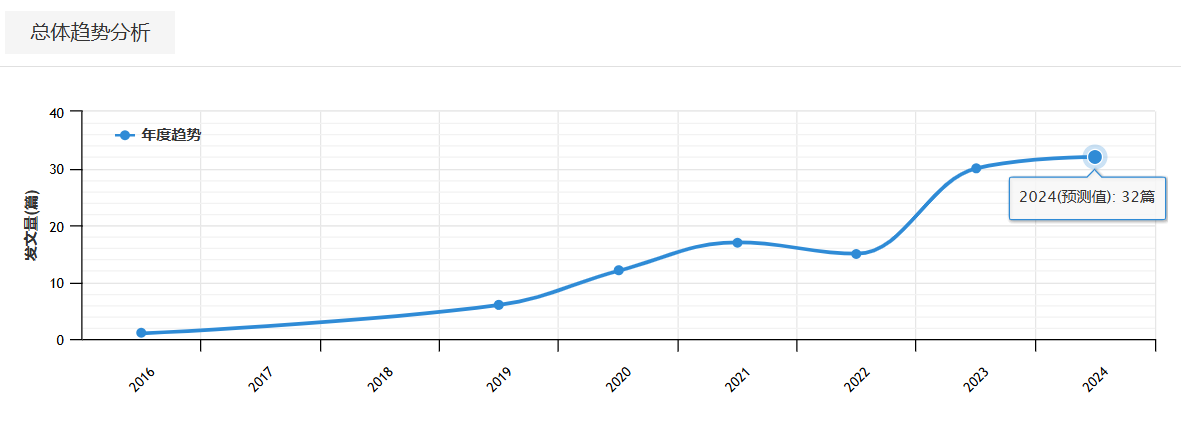

关键词:fiber optical&deep learning

来源:SCI、EI

引用:170

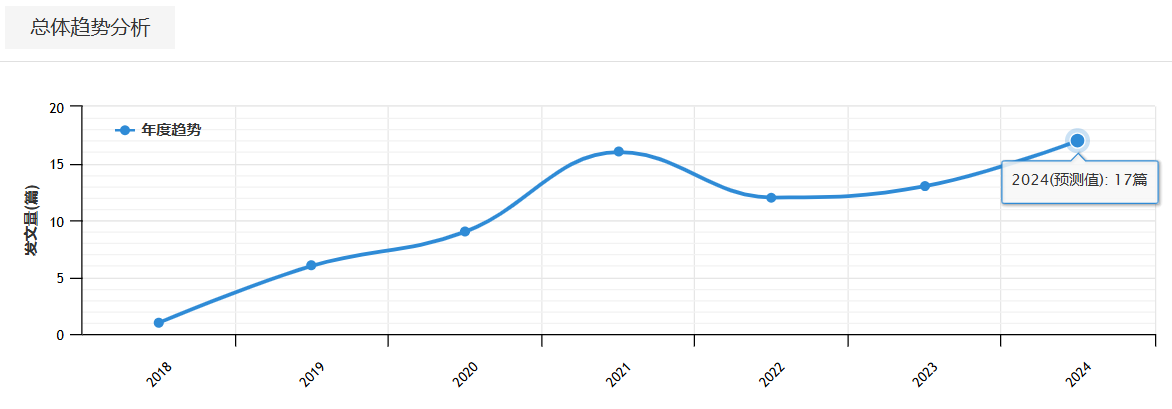

分布式光纤&机器学习的综述文章,有关算法有哪些,谁提出的,解决了什么问题

检索条件

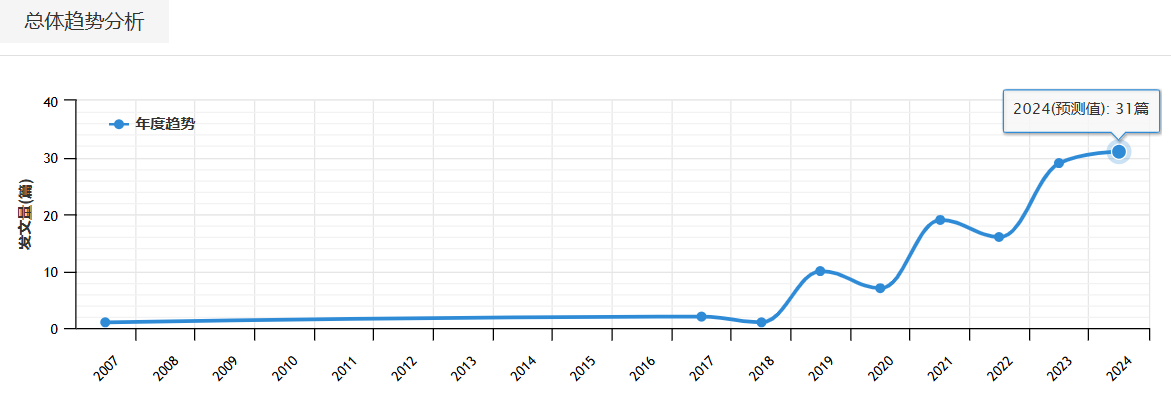

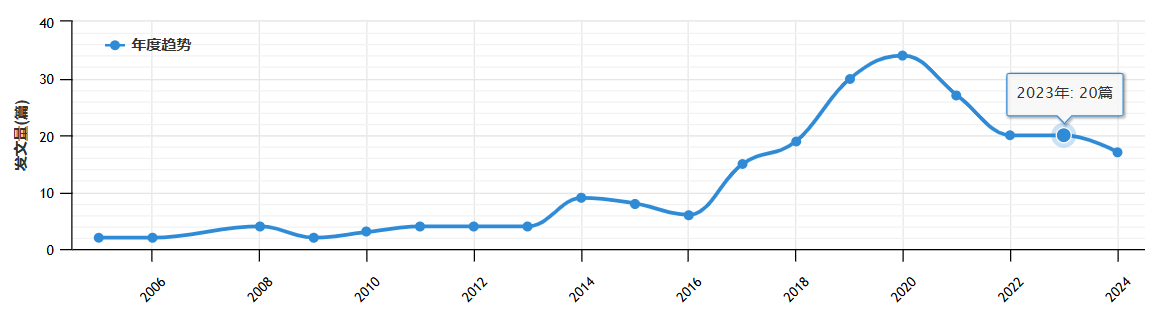

CNKI

光纤传感&机器学习

光纤传感&深度学习

光纤传感&模式识别

光纤传感&CNN

光纤传感&神经网络

房价预测。

好的,对于图像处理来说,我们可以把每一个像素看成一个输入。图像识别中,图像特征相对位置不固定。

对于一些情况来说,并不总是线性的,简化图像,我们不能通过对某几个像素简单的线性组合就来确定一个图像是否是一只猫狗,识别一个物品是需要综合多种特征考虑的。这个时候我们可以把输出看出某种特征的判定。