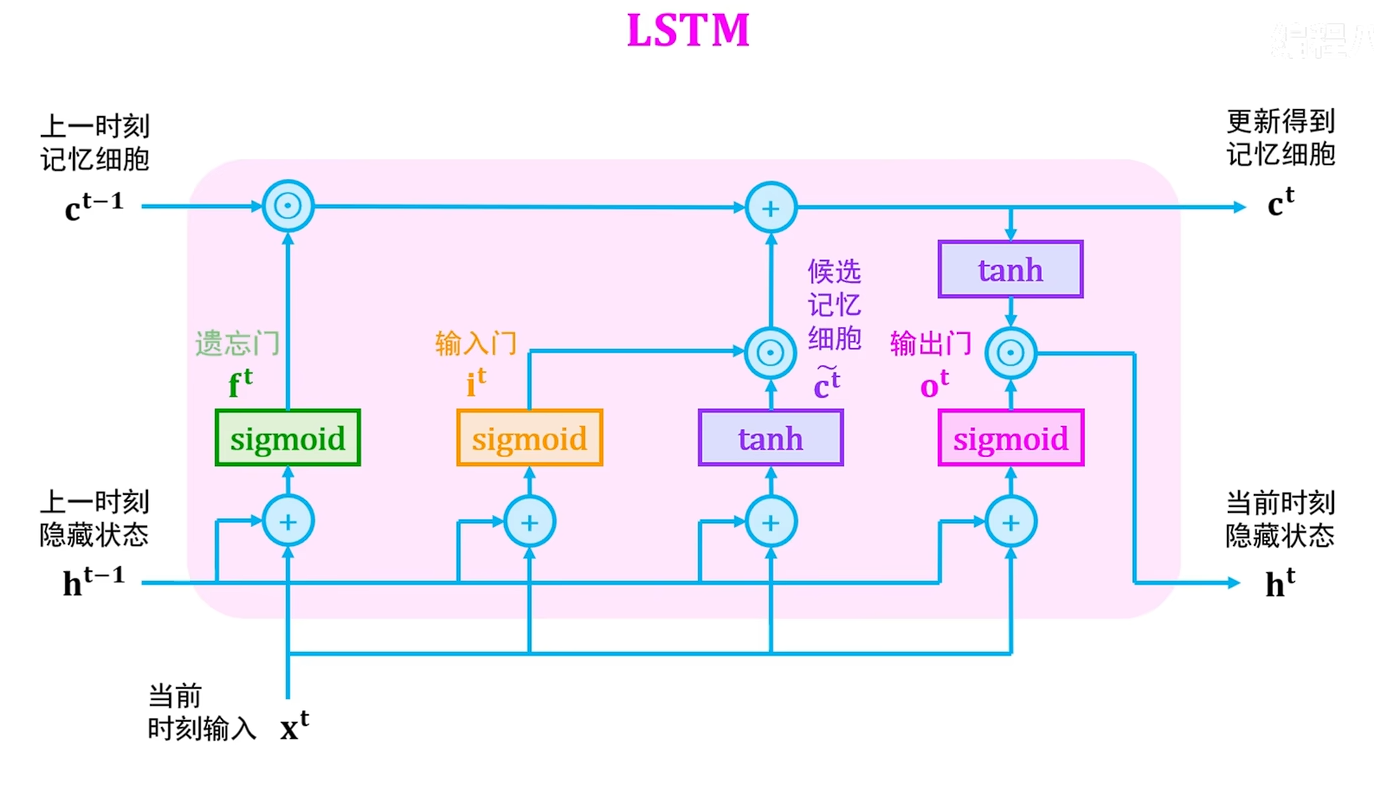

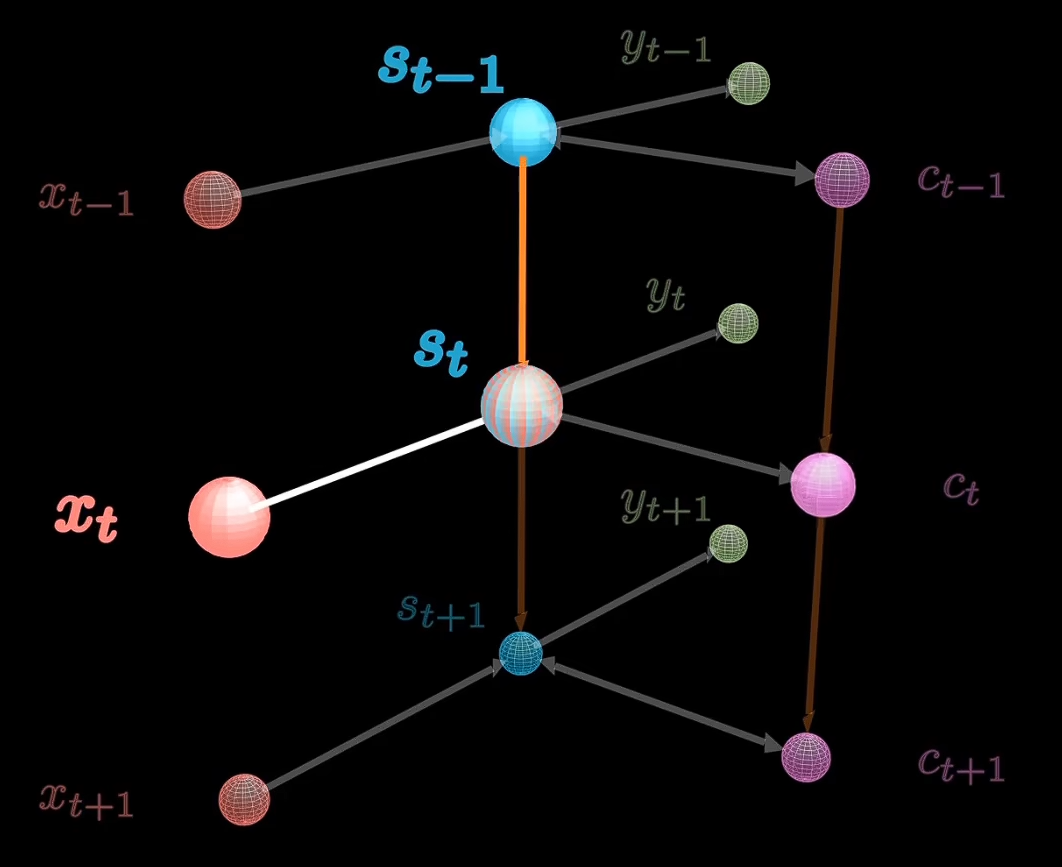

LSTM

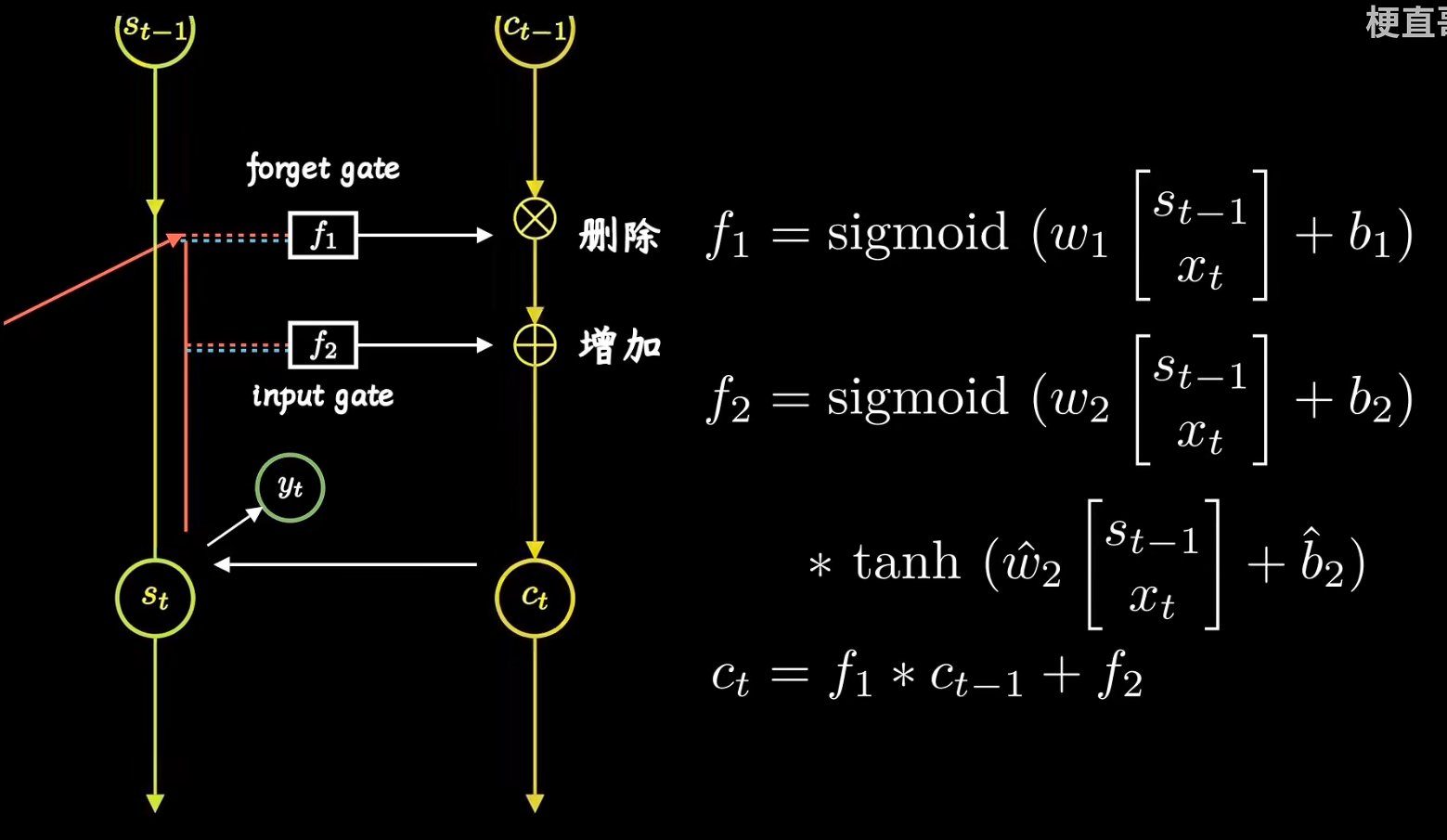

第一阶段

决定了将要记住的长期记忆的百分比

第二阶段

确定我们应该如何更新长期记忆

通常被叫做输入门

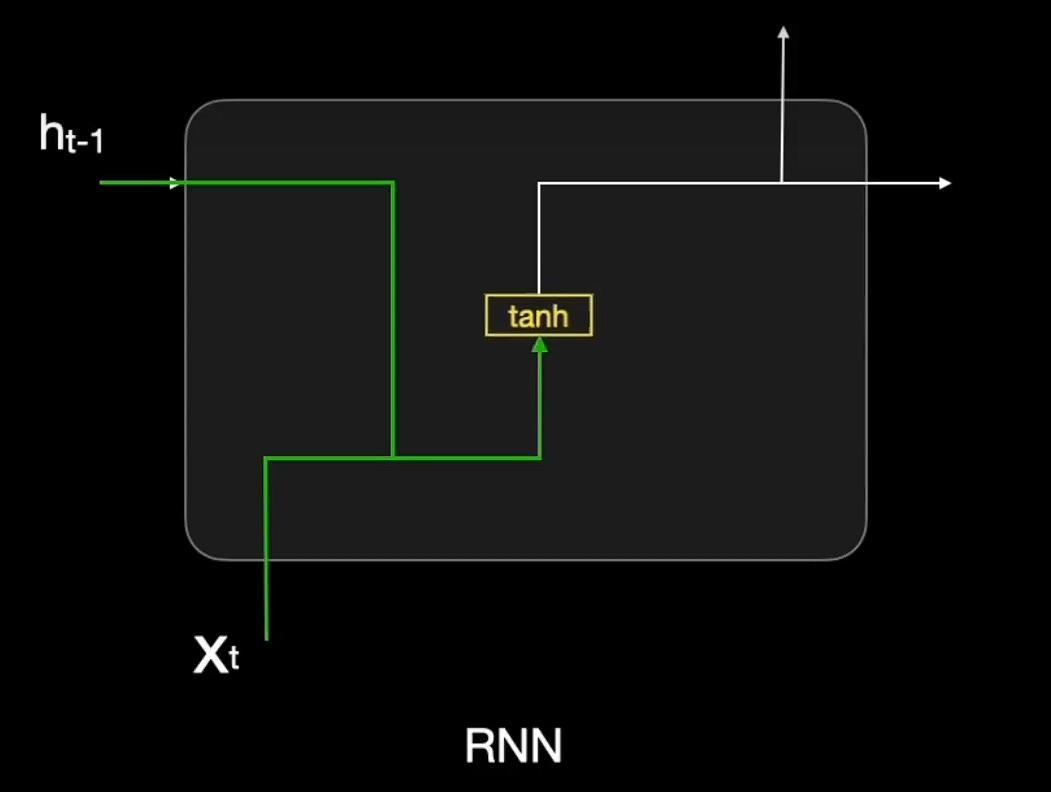

长期记忆网络避免了梯度爆炸/消失的问题

比起普通循环神经网络,意味着我们可以更多次展开它们,以适应更长的输入数据序列

遗忘阶段》上一时刻保留记忆》

选择记忆阶段:输入门元素越大,当前时刻信息会越多的被记入记忆细胞中》加上当前时刻添加记忆》更新得到记忆细胞

=====相当于早期时刻和当前时刻之间搭建了类似跨层连接的操作,可以解决长时依赖问题和缓解梯度衰减问题

LSTM

http://example.com/2024/12/14/20241214_LSTM/